15. Representation Learning

前馈网络:我们可以将监督学习训练的前馈网络视为表示学习的一种形式。

具体地,网络的最后一层通常是线性分类器,如softmax回归分类器。 网络的其余部分学习出该分类器的表示。

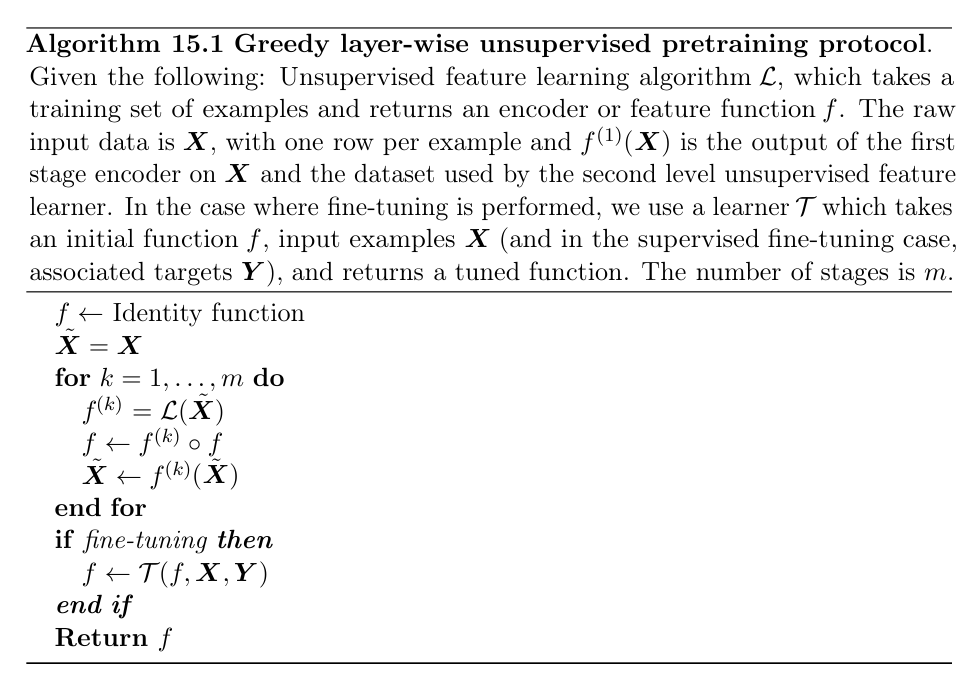

贪心逐层无监督预训练(Greddy Layer-Wise Unsupervised Pretrain):贪心逐层无监督预训练依赖于单层表示学习算法,例如RBM、单层自编码器、稀疏编码模型或其他学习潜在表示的模型。

每一层使用无监督学习预训练,将前一层的输出作为输入,输出数据的新的表示。 贪心逐层无监督预训练被称为贪心的,是因为它是一个贪心算法,这意味着它独立地优化解决方案的每一个部分,每一步解决一个部分,而不是联合优化所有部分。 它被称为逐层的,是因为这些独立的解决方案是网络层。

具体地,贪心逐层无监督预训练每次处理一层网络,训练第kk层时保持前面的网络层不变。无监督预训练结合了两种不同的想法:

第一,它利用了深度神经网络对初始参数的选择,可以对模型有着显著的正则化效果(在较小程度上,可以改进优化)的想法。

第二,它利用了更一般的想法——学习输入分布有助于学习从输入到输出的映射。

从无监督预训练作为学习一个表示的角度来看,我们可以期望无监督预训练在初始表示较差的情况下更有效,一个重要的例子是词嵌入。

从无监督预训练作为正则化项的角度来看,我们可以期望无监督预训练在标注样本数量非常小时很有帮助。

大部分算法已经不使用无监督预训练了,但是在自然语言处理领域中单词作为one-hot向量的表示不能传达相似性信息,并且有非常多的未标注数据集可用。

迁移学习(transfer learning)和领域自适应(domain adaption):指的是利用一个情景(例如,分布P1)中已经学到的内容去改善另一个情景(比如分布P2)中的泛化情况。

在迁移学习中,学习器必须执行两个或更多个不同的任务,但是我们假设能够解释P1变化的许多因素和学习P2需要抓住的变化相关。比如,许多视觉类别共享一些低级概念,比如边缘、视觉形状、几何变化、光照变化的影响等等。

在领域自适应的相关情况下,在每个情景之间任务(和最优的输入到输出的映射)都是相同的,但是输入分布稍有不同。

一次学习(one shot learning): 只有一个标注样本的迁移任务被称为一次学习,第一阶段学习出的表示就可以清楚地分离出潜在的类别,所以一次学习是可能的。

在迁移学习阶段,仅需要一个标注样本来推断表示空间中聚集在相同点周围许多可能测试样本的标签。

零次学习(zero shot learning):没有标注样本的迁移任务被称为零次学习,例子:一个学习器已经读取了大量文本,然后要解决对象识别的问题。

如果文本足够好地描述了对象,那么即使没有看到某对象的图像,也能识别出该对象的类别。

例如,已知猫有四条腿和尖尖的耳朵,那么学习器可以在没有见过猫的情况下猜测该图像中是猫。

”什么原因能够使一个表示比另一个表示更好?”:这是表示学习的一个重要问题。一种假设是,理想表示中的特征对应到观测数据的潜在成因,特征空间中不同的特征或方向对应着不同的原因,从而表示能够区分这些原因。